靠 总算搞定了,跟题主一模一样的异常信息

首先肯定是版本问题,编译版本问题。如楼上所说sbt配置spark-core的版本应该有问题。

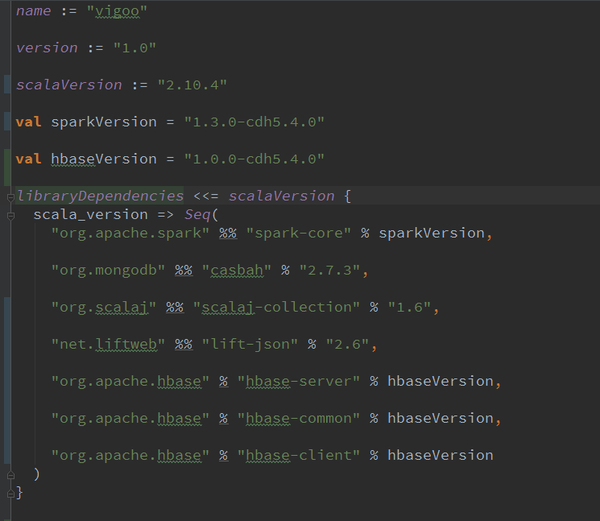

贴我的配置 注意各个依赖配置区别,%%和%的区别,%%会带scala版本信息,spark-core也就会变成spark-core_2.10,因为这里scala_version是2.10.4(.4就不要了),然后构建打包执行成功,一定要重新project structure。注意各个依赖配置区别,%%和%的区别,%%会带scala版本信息,spark-core也就会变成spark-core_2.10,因为这里scala_version是2.10.4(.4就不要了),然后构建打包执行成功,一定要重新project structure。

注意各个依赖配置区别,%%和%的区别,%%会带scala版本信息,spark-core也就会变成spark-core_2.10,因为这里scala_version是2.10.4(.4就不要了),然后构建打包执行成功,一定要重新project structure。注意各个依赖配置区别,%%和%的区别,%%会带scala版本信息,spark-core也就会变成spark-core_2.10,因为这里scala_version是2.10.4(.4就不要了),然后构建打包执行成功,一定要重新project structure。

之前是scala_version是2.11.7,而且没有带scala版本信息去编译。由于用的CDH,CDH中的依赖也没有spark-core_2.11,只有spark-core_2.10。